Il voice cloning è la nuova ‘arma’ dei truffatori

Con questa tecnologia in pochi secondi si replicano toni e cadenze delle vittime

740

CONDIVISIONI

3.5k

VISUALIZZAZIONI

Articoli Recenti

Scoperta in Argentina la più antica specie di pterosauri

Dicembre 31, 2024 - Aggiornamento Gennaio 1, 2025

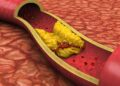

Attenzione al colesterolo: è un nemico silenzioso ma molto pericoloso

Dicembre 31, 2024 - Aggiornamento Gennaio 2, 2025

Pancia gonfia durante le feste: le cause e cosa fare

Dicembre 31, 2024 - Aggiornamento Gennaio 2, 2025

Eventi astronomici 2025: ecco quelli da segnare in agenda

Dicembre 30, 2024

Diabete mellito: falsi miti e consigli utili per la prevenzione

Dicembre 30, 2024 - Aggiornamento Gennaio 2, 2025

Scoperta una nuova specie fossile di armadillo

Dicembre 29, 2024 - Aggiornamento Gennaio 2, 2025

WhatsApp dice stop al supporto per vecchi smartphone nel 2025

Dicembre 27, 2024

Cannabis e cervello: il sorprendente ruolo anti-invecchiamento

Dicembre 27, 2024

Social media: ecco Cyd, il tool per cancellare le tracce da X

Dicembre 27, 2024

Link Utili

Ultimi Articoli

Scoperta in Argentina la più antica specie di pterosauri

Dicembre 31, 2024 - Aggiornamento Gennaio 1, 2025

Attenzione al colesterolo: è un nemico silenzioso ma molto pericoloso

Dicembre 31, 2024 - Aggiornamento Gennaio 2, 2025

Tag

alimentazione

ambiente

ansia

astrofisica

astronomia

bambini

batteri

benessere

cambiamenti climatici

cambiamento climatico

cancro

cervello

ChatGPT

covid

cuore

cura

depressione

diabete

Dna

Google

Ictus

Infarto

Innovazione

Intelligenza Artificiale

malattia

Medicina

nuove tecnologie

obesità

pelle

prevenzione

Psicologia

ricerca

salute

scienza

scoperta

scoperte

smartphone

social

sonno

spazio

studio

Tecnologia

tumore

tumore al seno

tumori

© 2023 Near Future - Testata Giornalistica registrata al Tribunale di Napoli (Registrazione n. 31 del 21/07/2022)

Gruppo Editoriale: USB - Animalsland - Findyourtravel - Foodando - Worldculture